Une illusion de progrès… et une réalité de surveillance

Les dangers de l’intelligence artificielle ne sont plus une théorie lointaine. Ils sont devenus une réalité quotidienne, souvent invisible, mais profondément structurante. Sous couvert de progrès, de confort et de performance, une technologie autrefois marginale s’est insinuée dans tous les pans de notre vie. Et sans véritable débat public, elle transforme notre société à grande vitesse.

L’IA est partout. Dans nos téléphones, nos voitures, nos banques, nos hôpitaux. On la présente comme une alliée objective, une assistante puissante qui nous libère des tâches pénibles. Pourtant, les dérives de l’intelligence artificielle sont déjà à l’œuvre : surveillance renforcée, décisions automatisées sans recours humain, exploitation massive de données personnelles, marginalisation des individus par des algorithmes opaques.

Le mythe du progrès technologique inoffensif vole en éclats quand on regarde ce qui se trame en coulisses. L’intelligence artificielle, loin d’être neutre, est devenue un levier de pouvoir, souvent piloté par des intérêts privés, financiers et géopolitiques. Elle sert autant à classer, trier et évaluer… qu’à contrôler.

C’est ce que dénonce Emmanuelle Darles, chercheuse en mathématiques appliquées à l’informatique, dans son livre IA : Illusion d’avenir, publié aux Éditions marco pietteur. Un ouvrage coup de poing qui analyse, décortique et expose les vrais enjeux éthiques, sociaux et politiques de l’IA.

Dans cette interview percutante menée par Jean-Dominique Michel, elle donne un aperçu saisissant de ce que nous refusons encore trop souvent de voir.

À travers ce dialogue éclairant, on comprend que le risque de dérive autoritaire par l’IA n’est pas un fantasme dystopique. C’est une dynamique déjà enclenchée. Et c’est à chacun de nous de décider s’il veut la subir… ou y résister.

👉 Découvrez le livre IA : illusion d’avenir: Le livre qui révèle comment l’intelligence artificielle menace déjà votre liberté.

L’IA n’est pas intelligente mais elle est redoutablement efficace

L’un des plus grands dangers de l’intelligence artificielle, c’est qu’elle porte un nom trompeur. Le mot “intelligence” suggère une capacité de raisonnement, d’analyse critique, voire de conscience. En réalité, les systèmes d’IA actuels ne font que manipuler des données en suivant des modèles probabilistes.

Ils ne comprennent rien à ce qu’ils produisent. Ils ne “pensent” pas. Ils calculent.

C’est précisément cette confusion sémantique qui alimente la fascination. Nous prêtons à l’IA des intentions qu’elle n’a pas, et nous lui confions des décisions qu’elle ne devrait jamais prendre. Ce glissement progressif, de l’assistance technique à la délégation du jugement, est l’un des aspects les plus sournois de la dérive actuelle.

Emmanuelle Darles insiste sur ce point : les algorithmes, aussi puissants soient-ils, ne savent pas pourquoi ils produisent une réponse. Ils se basent sur des corrélations, pas sur des causes. Et pire encore: leur fonctionnement est si complexe (notamment dans le cas du deep learning) qu’ils deviennent impossibles à auditer. Même leurs créateurs ne peuvent expliquer certaines décisions.

Ce phénomène, appelé “effet boîte noire”, est particulièrement inquiétant dans les domaines sensibles : santé, justice, emploi, éducation. Des vies peuvent être affectées, voire brisées, par des décisions automatisées sans que personne ne puisse en assumer la responsabilité.

Ce déni de responsabilité algorithmique est l’un des risques majeurs liés à l’intelligence artificielle, car il crée un vide moral et juridique dangereux.

Imaginez un médecin qui refuse un traitement vital parce que “l’IA n’est pas favorable”.

Ou un juge qui alourdit une peine sur la base d’un score de récidive calculé par une machine.

Ou un recruteur qui rejette un candidat parce qu’un algorithme a identifié “un risque d’instabilité” sur son profil LinkedIn. Dans tous ces cas, l’humain s’efface, et laisse place à un mécanisme aveugle.

Et pourtant, ces situations ne relèvent pas de la science-fiction. Elles existent déjà. Ce sont les dérives de l’intelligence artificielle dans leur forme la plus insidieuse: celle où nous oublions qu’elle n’est qu’un outil, et non une autorité.

L’infrastructure d’un crédit social européen est déjà là

Quand on évoque les dangers de l’intelligence artificielle, une idée revient souvent: celle du crédit social à la chinoise.

Un système dans lequel vos comportements, vos opinions ou vos fréquentations sont surveillés, notés et sanctionnés.

Ce cauchemar dystopique, que beaucoup considèrent encore comme lointain ou caricatural, est pourtant déjà en cours d’implantation chez nous.

La grande différence, c’est que ce processus ne se fait pas de manière brutale ni explicite. Il se fait par couches successives, silencieuses et technocratiques, au nom de la modernisation, de l’efficacité et de la sécurité. Chaque brique, prise individuellement, peut sembler anodine. Mais regroupées, elles forment une architecture redoutable.

Prenons trois exemples concrets :

- Le EHDS (European Health Data Space) prévoit la centralisation des données médicales de 450 millions de citoyens européens. Ces données, d’une extrême sensibilité, sont hébergées sur des serveurs opérés par des multinationales (comme Microsoft), avec des protocoles développés par Google.

L’IA y jouera un rôle clé pour analyser, croiser et « optimiser » les décisions médicales… ou administratives. - L’identité numérique, déjà votée dans plusieurs pays européens, devient un sésame obligatoire pour accéder à de plus en plus de services publics.

Une fois liée à votre dossier médical, à votre compte bancaire et à vos activités en ligne, cette identité devient une clef universelle… mais aussi un point de contrôle unique. - L’euro numérique, en cours de test, rend chaque transaction monétaire traçable, stoppable et analysable en temps réel.

Combiné à l’IA, ce système permettrait de moduler les droits d’achat d’un individu selon son comportement, son empreinte carbone, ses « bonnes pratiques », ou toute autre variable définie par l’État ou une entité privée.

Ces trois piliers, santé, identité, monnaie, forment la base technique d’un système de notation comportementale à l’européenne. Et même s’il ne porte pas (encore) le nom de « crédit social », il en a toutes les caractéristiques fonctionnelles.

Comme le montre Emmanuelle Darles dans son livre, la mise en œuvre de ce système se fait sans véritable débat démocratique. Les citoyens ne sont pas consultés. Les décisions sont prises dans des arènes technocratiques ou privées, avec une opacité qui interroge. Et pendant ce temps, la société glisse doucement vers un modèle de gouvernance algorithmique, où la conformité est récompensée… et la dissidence rendue coûteuse.

Le risque ultime?

Un monde dans lequel vos droits dépendent de votre score social, généré par une IA dont vous ignorez tout.

L’IA aggrave les inégalités qu’elle prétend résoudre

Un autre des grands dangers de l’intelligence artificielle réside dans sa promesse la plus séduisante… et la plus trompeuse : celle de l’objectivité. On nous présente l’IA comme une solution « neutre », qui dépasserait les préjugés humains. Une technologie qui déciderait mieux que nous, plus vite, sans passion ni discrimination. Mais dans la réalité des faits, c’est l’inverse qui se produit.

L’IA ne fait que refléter les données avec lesquelles elle est nourrie. Et ces données, qu’elles proviennent d’historiques médicaux, judiciaires ou professionnels, sont truffées de biais sociaux, culturels, économiques et raciaux. En les ingérant, l’algorithme les apprend… et les reproduit à grande échelle.

Un exemple tristement célèbre est celui de l’outil de recrutement automatisé développé par Amazon. En analysant les CV des dix dernières années, l’IA a « appris » que les meilleurs candidats étaient des hommes.

Résultat : elle a commencé à écarter systématiquement les candidatures féminines. Non pas par malveillance, mais par logique mathématique. Elle reproduisait un système discriminatoire sans même en avoir conscience.

Dans le domaine médical, les biais de données peuvent être encore plus graves. Une étude publiée dans Science a révélé que 99 % des IA utilisées en santé présentaient des biais. Certaines applications de diagnostic cutané, par exemple, affichaient des taux d’erreur effarants,jusqu’à 50 %, sur les peaux foncées.

Pourquoi ?

Parce qu’elles avaient été entraînées presque exclusivement avec des images de peaux claires. Voici un article qui parle de ce biais pour des questions de santé.

Ces dérives de l’intelligence artificielle se retrouvent aussi dans la justice. Aux États-Unis, le logiciel COMPAS est utilisé pour prédire la probabilité de récidive d’un individu. Or, plusieurs enquêtes ont montré que les personnes afro-américaines se voyaient attribuer des scores de risque plus élevés à données équivalentes. Un algorithme raciste, sans l’avoir voulu.

Et ce n’est que la partie émergée de l’iceberg. Car dans tous ces cas, ce ne sont pas seulement des erreurs ponctuelles. Ce sont des mécanismes systémiques, installés au cœur des institutions, invisibles aux yeux du public, et très difficiles à contester.

C’est ici que se loge la véritable menace: l’automatisation des discriminations. Non pas comme accident, mais comme conséquence logique d’un système mal encadré, mal compris, et surtout… mal gouverné.

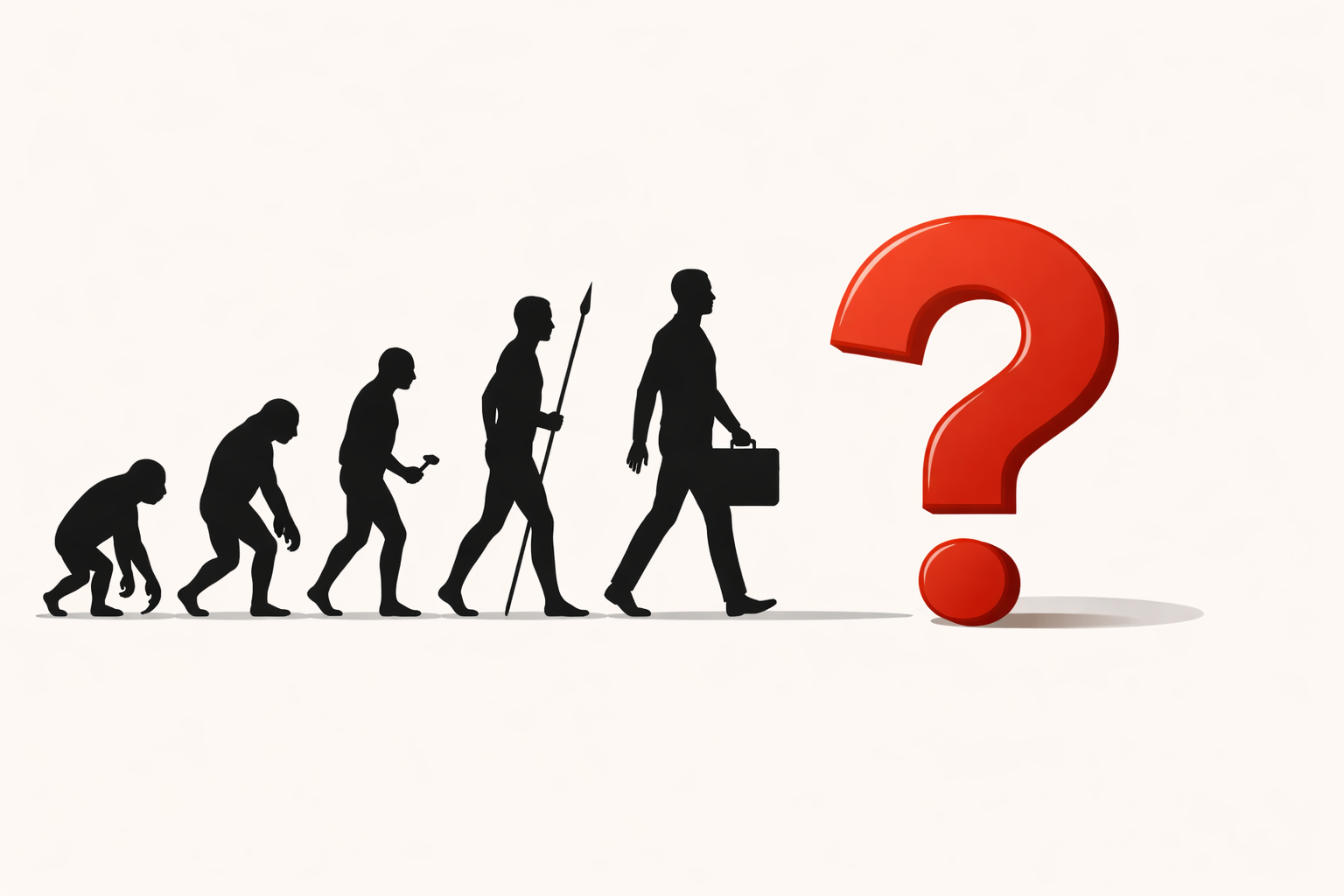

L’IA dégrade notre humanité, pas seulement nos libertés

Quand on parle des dangers de l’intelligence artificielle, on pense souvent à la surveillance de masse, à la perte de vie privée, au contrôle social. Mais il existe une autre forme d’érosion, plus lente, plus discrète, et tout aussi grave : l’atrophie de nos compétences humaines.

En déléguant chaque jour davantage de tâches cognitives aux machines, écrire un texte, résoudre un problème, générer une image, planifier une décision, nous affaiblissons notre propre intelligence.

Emmanuelle Darles, enseignante-chercheuse, observe ce phénomène de l’intérieur. Dans le milieu universitaire, elle constate une évolution préoccupante: les étudiants utilisent l’IA pour coder, pour rédiger, pour structurer… mais sans comprendre. La pensée s’appauvrit, la logique s’effondre, la langue se mécanise. On n’apprend plus à penser, on copie ce que l’algorithme propose.

Et ce phénomène dépasse largement les salles de classe. Dans la culture, dans l’art, dans la musique, l’IA générative recompose à partir de l’existant, en recyclant d’anciennes œuvres. Elle ne crée rien de nouveau. Mais si les humains cessent de produire des idées originales, alors l’IA, se nourrissant d’elle-même, tournera à vide. On entre dans une boucle de répétition, une culture de clones sans âme.

Cela peut sembler abstrait… jusqu’à ce que vous réalisiez que vos enfants apprennent aujourd’hui avec des outils qui leur mâchent tout, qu’ils s’expriment avec des textes qu’ils n’ont pas rédigés, qu’ils ne comprennent plus la nuance entre une réflexion authentique et une réponse générée. L’esprit critique recule. La créativité se dilue. La curiosité s’endort.

Le plus terrible? Ce phénomène est présenté comme un progrès. On parle de « gain de temps », d’ »aide à la productivité », de « démocratisation de la création ». Mais que vaut une société ultra-efficiente, si elle ne pense plus par elle-même?

C’est ici que se joue l’enjeu fondamental du livre IA: Illusion d’avenir. Il ne s’agit pas de rejeter toute technologie. Il s’agit de remettre l’humain au centre, de redonner de la valeur au vivant, à l’apprentissage, à l’imperfection aussi — car c’est là que se niche l’intelligence véritable.

Un appel à la conscience avant qu’il ne soit trop tard

Ce que révèle l’analyse d’Emmanuelle Darles, c’est que les dangers de l’intelligence artificielle ne sont pas seulement techniques ou économiques. Ils sont existentiels.

Ce que nous risquons de perdre, si nous restons passifs, c’est notre capacité collective à choisir, à penser, à créer, à vivre en êtres libres.

Nous assistons à une bascule: celle d’un monde piloté par l’humain, vers un monde dirigé par des systèmes algorithmiques, opaques, standardisés, calibrés pour l’efficacité… mais pas pour la justice, ni pour la vie.

Et cette transformation n’a rien d’inéluctable. Elle n’est pas naturelle. Elle est le fruit de décisions politiques, industrielles, culturelles.

Des décisions prises sans nous, mais qui nous concernent tous.

Alors que faire? Se résigner? Se laisser porter? Fermer les yeux?

Ou bien reprendre le débat, reprendre le contrôle, et surtout, comprendre.

C’est précisément ce que permet le livre IA : Illusion d’avenir. Ce n’est pas un simple essai.

C’est un outil. Une boussole. Un acte de lucidité.

En lisant ce livre, vous accédez à une analyse rigoureuse, accessible et implacable des dérives en cours, mais aussi à des pistes d’action claires, citoyennes, structurées.

IA : Illusion d’avenir aux Éditions marco pietteur

Par Emmanuelle Darles

🎯 Disponible dès maintenant ici sur cette page avec une réduction spéciale: IA : illusion d’avenir – Le livre qui révèle comment l’intelligence artificielle menace déjà votre liberté

C’est le livre que chacun devrait lire aujourd’hui pour comprendre dans quel monde il veut vivre demain.

Et vous, que pensez-vous des dangers de l’intelligence artificielle ?

Avez-vous déjà ressenti ses effets dans votre quotidien ?

👉 Partagez votre avis en commentaire, le débat est essentiel.