difficile à négocier humainement.

L’intelligence artificielle est partout.

Elle pilote nos choix, analyse nos comportements, suggère nos décisions.

Et elle est souvent présentée comme l’arme absolue pour réduire les injustices.

Mais si cette révolution technologique faisait… exactement l’inverse ?

Si, derrière les promesses d’efficacité et d’équité, l’IA servait en réalité à consolider les inégalités sociales, à les rendre invisibles, indiscutables… et automatiques ?

« IA et inégalités sociales » : deux notions que tout oppose en apparence.

Et pourtant, c’est peut-être le duo le plus explosif — et le plus dangereux — de notre époque.

Ce n’est pas de science-fiction qu’il s’agit ici. C’est votre avenir.

Et celui de millions de personnes, déjà jugées, notées, exclues… sans jamais savoir pourquoi.

Ce que promettait l’IA : l’illusion d’un progrès équitable

L’utopie algorithmique vendue par les géants de la tech

Depuis des années maintenant, on nous vend la même histoire :

L’IA va libérer l’humanité.

Elle va supprimer les tâches ingrates, rationaliser les décisions, réduire les biais humains.

« Plus de justice », disaient-ils.

« Moins de subjectivité, plus de vérité. »

C’est un storytelling parfait pour lever des milliards, attirer les gouvernements, séduire l’opinion.

Sauf qu’il repose sur un mythe.

Neutralité, efficacité, justice : une promesse séduisante mais biaisée

Les algorithmes ne sont pas neutres.

Ils sont programmés par des humains, avec leurs biais, leurs angles morts, leurs intérêts.

Et lorsqu’ils sont déployés dans des systèmes déjà inégalitaires — santé, logement, justice, emploi — ils n’égalisent pas.

Ils automatisent l’exclusion.

Ce qu’on vous présente comme un progrès équitable est, en réalité, une machine à standardiser l’injustice.

En rendant la décision technique, opaque, non contestable.

Résultat : l’inégalité devient une fonctionnalité, pas un bug.

Quand l’IA reproduit l’injustice : la grande illusion de l’objectivité

On nous l’a promis : l’intelligence artificielle allait corriger les injustices du monde. Supprimer les biais, éliminer les passe-droits, garantir une égalité réelle.

En théorie, rien de plus logique : des algorithmes rationnels, nourris par des données objectives, devraient prendre de meilleures décisions que les humains.

Moins d’erreurs. Moins de favoritisme. Moins de discrimination.

C’était le rêve technologique. Et il a séduit des millions d’esprits.

Mais dans la réalité, c’est tout l’inverse qui se produit.

L’IA ne supprime pas les inégalités sociales, elle les encode.

Elle apprend à partir de données issues d’un monde injuste — et elle reproduit ces injustices avec une précision algorithmique.

Si les riches ont historiquement eu plus accès aux soins, l’IA médicale le confirmera. Si certains profils ont été écartés du marché du travail, les IA de recrutement perpétueront ces exclusions.

Non pas par malveillance. Mais par simple fidélité aux données.

Cette prétendue objectivité est d’autant plus dangereuse qu’elle ne se voit pas.

Un algorithme ne crie pas, ne discrimine pas ouvertement.

Il trie, il note, il classe.

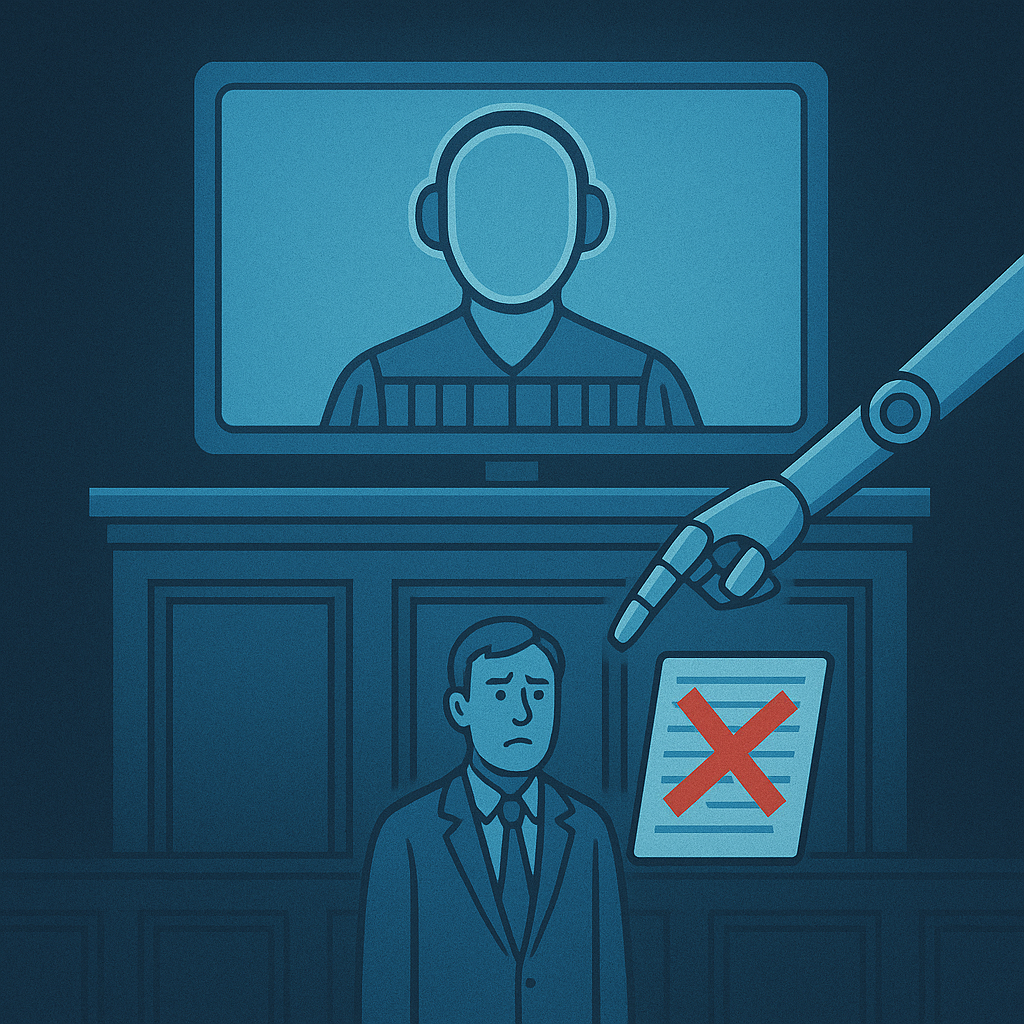

Et lorsque vous êtes rejeté d’un emploi, d’un logement ou d’un service public, vous n’avez personne à qui parler.

Pas de visage, pas de voix. Juste un score. Un pourcentage. Une décision automatisée.

L’injustice devient silencieuse, mathématique, incontestable.

Prenons des exemples concrets.

Dans plusieurs pays, des IA sont utilisées pour attribuer des logements sociaux, gérer l’ordre de passage dans les hôpitaux, filtrer les CV, ou encore détecter les comportements à risque à l’école.

À chaque fois, la promesse est la même : aider à prendre de meilleures décisions.

Mais ce que l’on cache, c’est que ces systèmes apprennent à partir de données historiques. Et que ces données sont pleines de discriminations passées.

Alors les décisions que prend l’algorithme ne sont pas neutres.

Elles sont codées sur les exclusions d’hier.

Une mère célibataire dans un quartier défavorisé ? Jugée instable.

Un jeune homme de banlieue ? Noté à risque.

Un CV venu d’une université inconnue ? Filtré.

Et le plus grave, c’est que personne ne comprend pourquoi.

Parce que l’algorithme ne s’explique pas. Il calcule, il évalue, il exécute. Sans rendre de comptes.

Ce pouvoir algorithmique s’appuie sur une matière première : les données.

Chaque clic, chaque déplacement, chaque mot prononcé ou tapé est capté, enregistré, analysé.

Nos vies deviennent des flux de données exploitables, marchandisables.

Mais attention : tout le monde ne produit pas les mêmes données, ni dans les mêmes conditions. Et cette inégalité-là est rarement évoquée.

Car ceux qui vivent dans des environnements connectés, éduqués, protégés, produisent des données “propres”, lisibles, interprétables.

Tandis que les populations marginalisées — précaires, en errance, isolées — laissent des traces floues, éparses, souvent interprétées de travers.

L’IA, n’ayant pas de contexte humain, comble les vides par des hypothèses.

Et c’est souvent là que surgissent les pires erreurs.

Parce que plus vous êtes vulnérable, moins vos données sont précises.

Et plus vous êtes à la merci d’une mauvaise prédiction.

Des décisions sans visage : l’injustice rendue automatique par l’IA

Et c’est précisément là que réside le danger : dans cette délégation aveugle.

On confie à des machines le soin de trancher des situations humaines, sans jamais interroger les fondements de leurs jugements.

Pire encore, cette automatisation donne l’illusion d’une décision juste, parce qu’elle est technologique.

Comme si le fait qu’une machine l’ait décidée rendait l’exclusion acceptable.

Ce récit de neutralité, martelé par les grandes entreprises technologiques, sert des intérêts très clairs.

Il renforce le pouvoir de ceux qui conçoivent les systèmes.

Il déresponsabilise les institutions.

Et il anesthésie le débat public.

Car comment remettre en question un calcul ?

Qui oserait défier une équation ?

Voilà comment l’IA et les inégalités sociales se renforcent mutuellement, en silence.

Un futur à deux vitesses : quand l’IA renforce les hiérarchies sociales

Le fantasme d’une IA au service de tous s’effondre lorsqu’on regarde qui la conçoit, qui la contrôle, et qui en profite.

Aujourd’hui, l’IA et les inégalités sociales ne sont pas des forces opposées. Elles avancent ensemble.

Tandis que certains conçoivent les systèmes, engrangent les données, dictent les règles… d’autres les subissent.

Les uns innovent, pilotent, dirigent. Les autres s’adaptent, obéissent, disparaissent des radars.

Ce modèle s’appelle le capitalisme algorithmique.

Une forme de gouvernance sans visage, où les décisions sont prises par des lignes de code, validées par des tableaux de bord, et jamais remises en cause.

Ce n’est plus une société humaine.

C’est un tableur géant, où la rentabilité a remplacé la justice, et où l’humain est réduit à une variable.

Réinventer l’IA : pour une technologie au service de l’humain

Mais ce futur n’est pas une fatalité. À condition de poser les bonnes questions.

De sortir du mythe technologique pour revenir à l’essentiel : à quoi voulons-nous que l’IA serve ?

Voulons-nous une intelligence artificielle qui optimise des profits ou qui renforce des libertés ?

Qui surveille les masses ou qui libère les individus ?

Qui encode le passé ou qui construit un avenir plus juste ?

Pour briser le cycle entre IA et inégalités sociales, il faut reprendre le pouvoir sur la technologie.

Cela passe par la transparence des algorithmes.

Par la responsabilité des concepteurs.

Par l’inclusion réelle de toutes les voix dans le débat.

Et par une exigence éthique : celle de ne jamais sacrifier l’humain au nom de l’efficacité!

Ce que révèle “IA : illusion d’avenir”

C’est précisément cette réflexion que propose le livre IA : illusion d’avenir.

Un essai percutant, publié aux Éditions marco pietteur, qui démonte les discours lisses et rassurants autour de l’intelligence artificielle.

Loin du jargon technique, cet ouvrage pose une question essentielle : qui profite vraiment de l’IA — et à quel prix ?

Ce n’est pas un livre pour experts.

C’est un manifeste accessible, rigoureux, qui vous aide à décoder les enjeux réels.

À comprendre comment l’IA et les inégalités sociales sont liées.

À voir au-delà du marketing technologique.

Et surtout, à retrouver un pouvoir de réflexion, face à des machines programmées pour penser à votre place.

Un livre pour reprendre le contrôle avant qu’il ne soit trop tard

IA : illusion d’avenir ne vous promet pas des réponses faciles.

Mais il vous donne les bonnes questions.

Celles qu’on ne pose jamais dans les médias.

Celles que les géants du numérique préféreraient que vous n’envisagiez jamais.

Car réfléchir, c’est résister. Et résister, c’est commencer à redevenir libre.

Ce livre agit comme un vaccin mental contre la manipulation algorithmique.

Il vous montre comment les systèmes fonctionnent, à qui ils profitent, et pourquoi il est urgent de sortir de cette fascination aveugle.

Si vous ne participez pas au débat, vous serez réduit à une ligne dans une base de données. C’est aussi simple — et brutal — que ça.

IA et inégalités sociales : un combat pour l’humanité

L’IA ne vous veut pas nécessairement du mal. Elle est un outil.

Mais entre les mains d’une technocratie mondialisée, elle devient un levier de domination silencieuse.

Et si vous ne prenez pas position, vous serez pris dans la mécanique. Pas en tant que sujet, mais en tant qu’objet.

Ce qui est en jeu ici dépasse la technologie.

C’est une question de société, de justice, de dignité. Il ne s’agit pas de rejeter l’IA, mais de la remettre à sa juste place : au service de l’humain, jamais au-dessus de lui.

Le livre IA : illusion d’avenir vous aidera à franchir ce cap.

À penser plus librement. Et à défendre ce qui compte vraiment : votre droit à décider.

Vous l’aurez compris : le débat autour de l’IA et des inégalités sociales n’est pas technique. Il est profondément politique, éthique, humain. Ce que nous faisons aujourd’hui de cette technologie déterminera le monde de demain. Et ce monde, vous en ferez partie — que vous le vouliez ou non.

Alors ne restez pas spectateur.

Lisez “IA : illusion d’avenir” dès maintenant

pour ne pas vous laisser programmer sans le savoir.

C’est plus qu’un livre : c’est une arme de lucidité face à une technologie devenue pouvoir.

👉 Commander le livre ici:

Et pour aller plus loin, découvrez 5 actions concrètes pour reprendre le contrôle sur l’IA dès aujourd’hui.

👉 Lire l’article ici

Et vous, qu’en pensez-vous ?

L’IA est-elle encore récupérable ? Ou déjà hors de contrôle ?

💬 Partagez votre point de vue en commentaire — chaque avis compte.